مع ازدياد التوجه لانتاج واستخدام الروبوتات ذاتية التحكم، احد الباحثين يطالب بتركيب “صندوق اسود اخلاقي” فيها Ethical Black Box. تأتي المطالبة هذه بعد حصول عدة حوادث ومخالفات تسببت بها روبوتات وسيارات ذاتية القيادة. وظيفة الصندوق الاسود ان يجمع البيانات والمعلومات التي اعتمد عليها الروبوت في اتخاذ قراره، ليتم الرجوع لها لفهم مسوغات القرار. فمثلا لو قررت سيارة ذاتية القيادة ان تنحرف فجأة واصطدمت بحاجز او جدار، هنا لابد الرجوع للصندوق الاسود لفهم هذا التصرف. لذا، لابد للصندوق الاسود ان يجمع بيانات من الحساسات والكاميرات والرادارات “الموجودة بالروبوت” ويجعلها متاحة للقراءة بعد المشكلة او الحادث. هناك جهاز شبيه بالصندوق الاسود موجود ببعض السيارات الان وهو مسجل البيانات Event Data Recorder. من وظائف هذا الجهاز تسجيل بيانات حالة السيارة قبيل الحادث مثل قوة الضغط على الفرامل، السرعة، درجة انحراف المقود، و حالة ربط حزام الامان. البيانات هذه تساعد المحققين على فهم اسباب حوادث السيارات بنسبة كبيرة خصوصا اذا كانت فيها غموض او كان السائق قد توفى او فاقد للوعي. أهمية الصندوق الاسود بالروبوتات ذاتية التحكم اكبر من مسجل بيانات السيارات، لان القرار بيد آلة وليس انسان ولابد من معرفة كيف “فكرت” هذه الآلة. الصندوق الاسود الاخلاقي يتيح للمحققين معرفة المسؤول عن الحادث الذي تسبب به الروبوت او السيارة ذاتية القيادة. فربما يكون سبب المشكلة او الحادث خلل بالحساسات، سوء تقدير، خطأ بتغذية البيانات “انحياز” او اغراق بمعلومات مضللة تشتت الروبوت. وهناك امثلة:

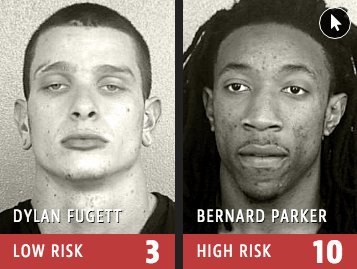

هذا مثال لسوء تغذية الروبوت بالبيانات مما جعله يتخذ قرارات منحازة او عنصرية (هل الذكاء الاصطناعي دائما على حق؟)

وهذا مثال آخر على اغراق الروبوت بمعلومات مضللة مما جعله يتخذ قرارات “ينشر تغريدات” عنصرية (روبوت مايكروسوفت للدردشة – تم ايقافه بعد ٢٤ ساعة من اطلاقه)

بعض الروبوتات ذاتية التحكم فيها خاصية التعلم الآلي ولو تعلم الروبوت معلومة خاطئة فسيتخذ قرار خاطئ بناءً عليها. وهنا تأتي أهمية الصندوق الاسود. فالصندوق الاسود يبين مصدر هذه المعلومة الخاطئة ومن علمها الروبوت ليتم تحديد المسؤول عن المشكلة “المصنع، المبرمج، المالك، المستخدم أو البيئة”. وجود الصندوق الاسود بالروبوتات ينعكس على ثقة المجتمع بها، فسيعرف المجتمع كيف تفكر الروبوتات وكيف تتخذ قراراتها (هل سنثق بسيارة ذاتية القيادة تضحي بنا؟).

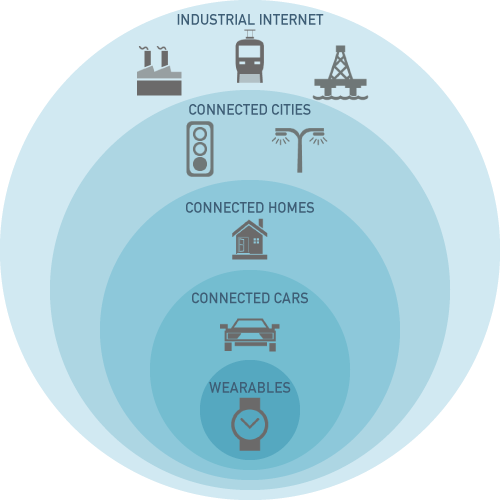

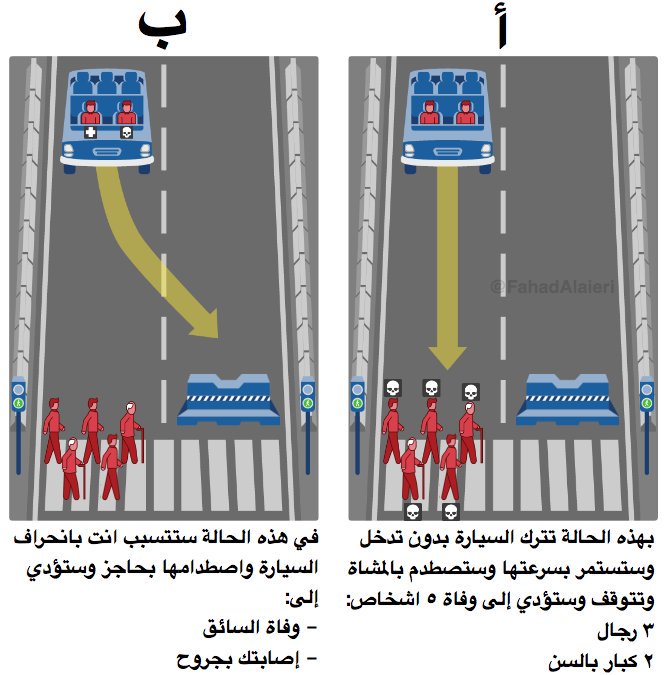

انترنت الاشياء الروبوتية Internet of Robotic Things

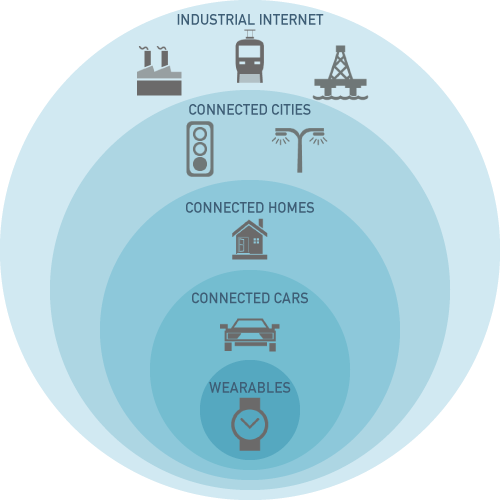

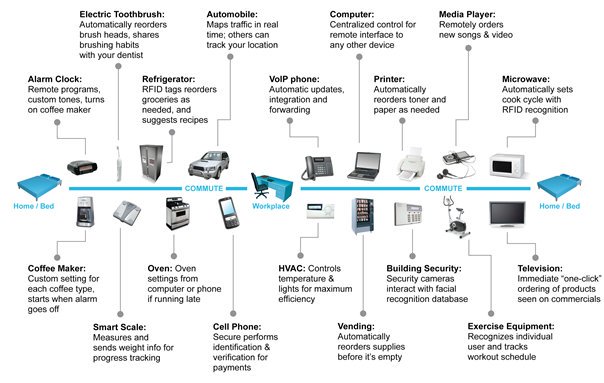

عصر انترنت الاشياء Internet of Things

كل شي سيكون متصل بالانترنت، اجهزة وحساسات بالبيت، سيارات، بنية تحتية، حتى المواصلات العامة والمحلات والمكاتب والمصانع

بيوت ذكية، سيارات ذكية، مدن ذكية، مواصلات ذكية، اسواق ومصانع ذكية

حتى الغابات والبحار ستكون متصله بالانترنت لقياس الجودة والتلوث

آلاف الاجهزة والحساسات حولنا ستجمع بيانات عن كل شي، فمثلا المستخدم يعرف حال بيته وسيارته ومكتبه والحكومة تعرف حال الخدمات والمصالح

الاجهزة والآلات والحساسات لن تبقى جامعة للبيانات فحسب، بل ستتطور وتتخذ قرارات نيابة عن الانسان وتنفذ المهام

وهذا عصر انترنت الاشياء الروبوتية Internet of Robotic Things

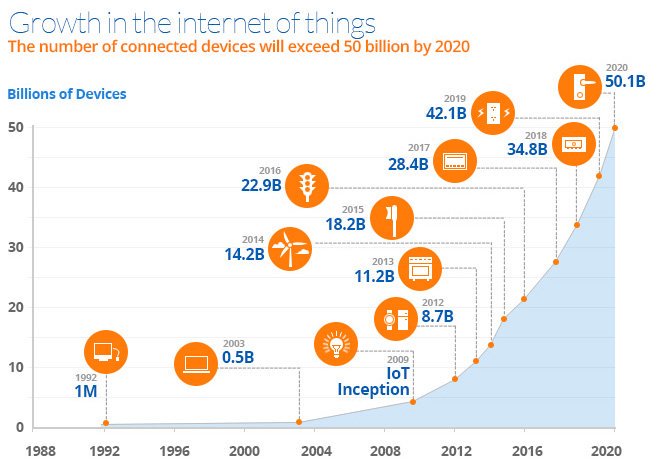

لذلك بالمستقبل القريب سنجد مصانع تشغل نفسها، حافلات تقود نفسها، محلات بدون بائع، مطاعم بدون طباخ، مكاتب خدمية بدون موظفين. ويقدر ان تصل عدد الاجهزة المتصلة بالانترنت في عام ٢٠٢٠ اكثر من ٥٠ مليار جهاز حول العالم

سنكون محاطين بالحساسات والكاميرات والاجهزة الذكية

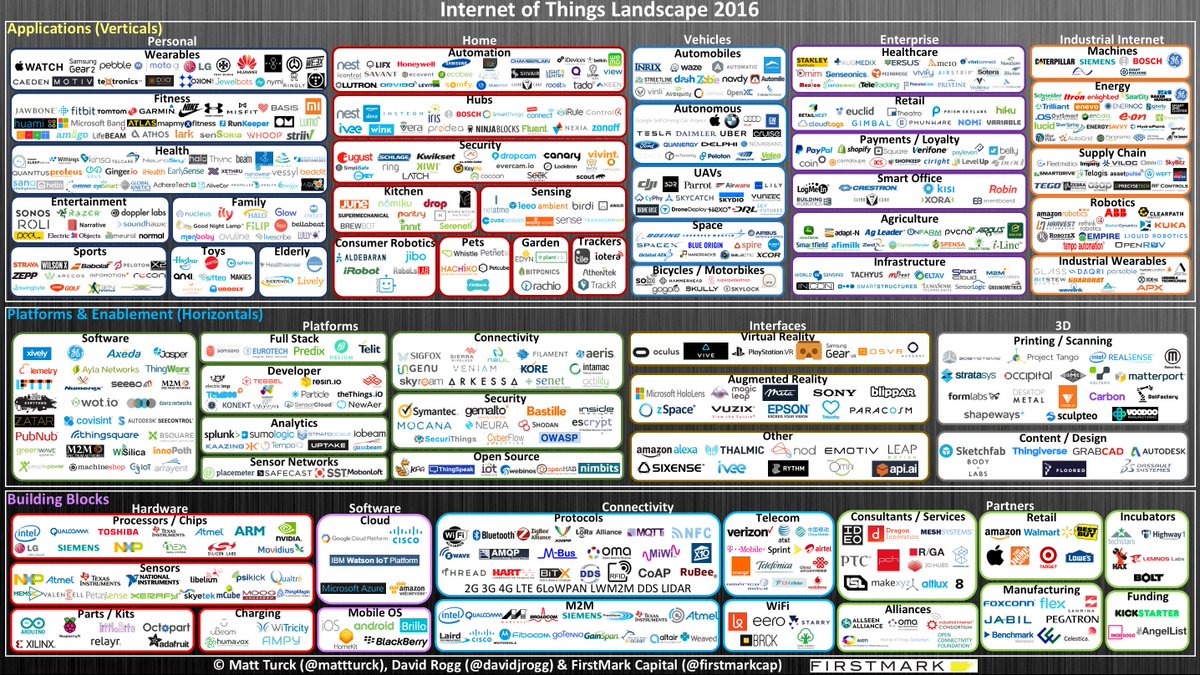

حجم السوق ضخم جدا، هناك عشرات الشركات المنتجة لتقنيات “الاشياء”

من تقنيات شخصية حتى تقنيات مصانع

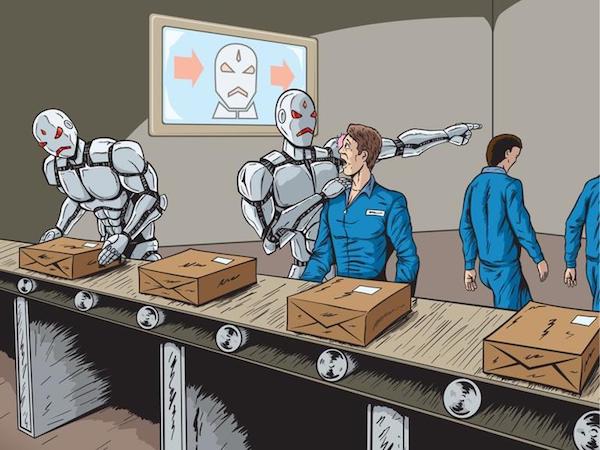

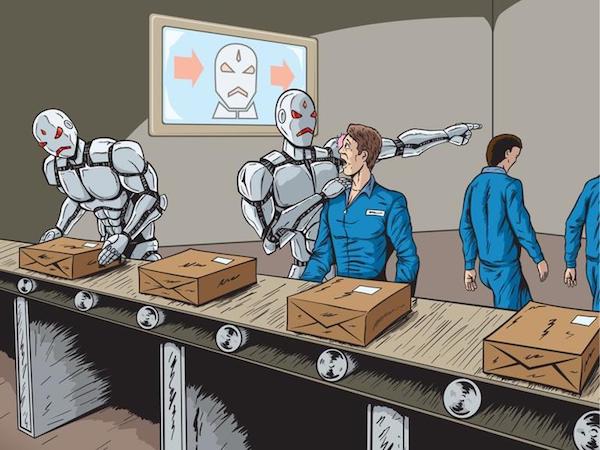

الروبوت ووظائف البشر – ضريبة استخدامه وتأثيره على الدول النامية

الروبوتات يجب ان تدفع ضريبة دخل للدولة!

هذا مقترح قاله بعض الخبراء، وذُكر في احد تقارير البرلمان الأوروبي وآخر من أثاره بالاعلام بيل غيتس. في كثير من الدول الموظف يدفع ضريبة تعود على الرعاية الصحية، الطرق والخدمات، واذا صار الموظف عاطل بسبب الروبوت سيُحرم المجتمع من خدمات كثيرة. توظيف الروبوت بدل الانسان أمر اصبح واقع وملموس ببعض الدول، لكن المشكلة كيف يتم اقرار الضريبة على الروبوت او الشركة المشغلة! كيف يتم احتسابها؟ هل الروبوت الواحد يقابل موظف واحد؟ او اكثر؟ بعض الروبوتات تفوق قدرتها قدرة الانسان من حيث السرعة والدقة والعمل المتواصل، يعني ربما روبوت واحد يفوق ٥ او ١٠ عمال! كيف ستحسب الضريبة؟ فالشركات التي ستخفض تكاليفها من خلال احلال الروبوت مكان موظفيها ستواجه تكاليف من نوع آخر تُدفع للدول مقابل الأتمتة. وربما يصدر بهذا قانون جديد!

قبل فترة وبناءا على دراسات تحدثت عن الوظائف التي سيأخذها الروبوت (فيديو – ماهي الوظائف التي سيأخذها الروبوت من الانسان؟)، لكن هناك تقارير تقول ان الوضع خطر على الدول النامية. صدر تقرير جديد من الامم المتحدة يقول ان زيادة استخدام الروبوت في الدول المتقدمة يهدد الدول النامية من حيث انخفاض كلفة العمالة هناك. كثير من الشركات العالمية تتجه بمصانعها للدول النامية/الفقيرة بسبب رخص اليد العاملة. لكن زيادة استخدام الروبوت من قبل هذه الشركات سيغير الوضع. انخفاض تكلفة الروبوت وتعدد استخداماته سيفقد الدول النامية ميزتها من حيث انخفاض كلفة العامل. سيكون انتاج الشركات معتمد على الروبوت محليا أي في منشئها. فبإمكان الشركات في الدول المتقدمة ان تستخدم روبوتات “منخفضة التكلفة على المدى الطويل” في مصانعها المحلية لعمليات التجميع والانتاج. معنى هذا ان الشركات العالمية ستغادر الدول النامية وتترك الآلاف من اهلها بدون وظائف. وربما يستفحل الفقر وتزيد البطالة. حيث هناك تقرير آخر من البنك الدولي يقول ان الأتمتة “بما فيها استخدام الروبوت” ستقضي على ثلثي الوظائف في الدول النامية.

فيديو – ماهي الوظائف التي سيأخذها الروبوت من الانسان؟

فيديو – اخلاقيات الروبوت

هل ستنقلب علينا الروبوتات مستقبلا وتتحكم بنا؟ هل ممكن ان تخرج عن سيطرة صانعها؟ هل ممكن ان تؤذي الانسان باتخاذ قرار خاطئ؟ لحماية البشرية من هذه الاحتمالات، يجب ان يتم ضبط قرارات وتصرفات الروبوتات مستقبلا وذلك عبر توجيهها بقوانين ومفاهيم ومبادئ.

عقبات اجتماعية ستواجه السيارات ذاتية القيادة

في عدة مواقع ذكرت ان اشكاليات السيارات ذاتية القيادة ليست تقنية فقط بل هناك اشكاليات اجتماعية واخلاقية. مثل: هل سنثق بسيارة ذاتية القيادة تضحي بنا؟

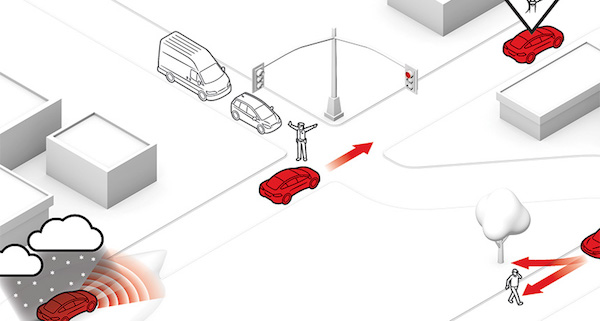

القيادة الذاتية بالسيارات تختلف عن الطيار الآلي بالطائرات، في الطرق البيئة غير منظمة Unstructured Environment، اما في السماء فالبيئة منظمة. بمعنى ان الطيار الآلي يتبع مسار معين مع وجود مراقبين وتعليمات. اما في الطرق فالمفاجآت واردة وهي سبب كثير من الحوادث. حاليا اغلب السيارات ذاتية القيادة لا تستطيع تمييز الحيوانات الصغيرة والحفر والاحجار والتي قد تسبب خلل بالاجهزة والحساسات والاطارات. هذا غير الحيوانات التي تقفز بشكل سريع ومفاجئ على الطريق. في امريكا هناك قرابة مليون حادث سنويا بسبب خروج الغزلان والموس “الموظ” على الطرق:

حتى ان هناك اختبار اسمه Moose Test يتم اجراؤه على السيارات حيث يعتمد على المناورة ويختبر قدرة السيارة على تجاوز الموس او الغزال اذا خرج فجأة امام السائق

يضاف لهذه الصعوبات التقنية خلل الحساسات او الرادار بسبب الحصى المتطاير او ضعفها بسبب الاجواء “ثلج، غبار،..” او اختفاء الخطوط الارضية بالطريق. هذي من ناحية تقنية، اما من ناحية اجتماعية واخلاقية فهناك قوانين غير مكتوبة يتبعها السائقين ببعض البلدان تنظم سيرهم بالطرقات. مثل تواصل السائقين بين بعضهم او مع المشاة بالاشارات اليدوية او الاتصال البصري. احيانا اشارة اليد او نظرة يفهم منها الطرف الآخر السماح بالمرور.

هل لدى السيارة ذاتية القيادة قدرة ان تفهم “تميز” هذه الحركات والاشارات من السائقين الآخرين. هل نظامها مهيأ لمراقبة سائق كل سيارة حولها! نفس الفكرة بالنسبة لرجل المرور منظم السير. هل ستفهم اشاراته وحركاته وتتبعها ام تتبع النظام, علما ان الحركات غير موحدة وتختلف احيانا بين الدول.

واذا كان نظام السيارة ذاتية القيادة قادر على فهم حركات رجل المرور، ماذا لو وقف شخص من المشاة امامها وعمل نفس الحركات! هل ستتبعه؟ وهذا ينقلنا لتعامل المشاة والسائقين الاخرين مع السيارة ذاتية القيادة اذا عرفوا انها ذاتية وعرفوا انها تتبع النظام بدقة. هناك تخوف من “التنمر” ضد السيارات ذاتية القيادة Bully Self-Driving Cars ربما يتجاوز عليها السائقين الاخرين او يقف امامها المشاة. وقد حدث هذا فعلا في بعض الاختبارات لهذا النوع من السيارات. لذلك هناك مطالبة ان تكون السيارة ذاتية القيادة قاسية ضد من يتجاوز عليها. وقد طالب بعض المهتمين ان يكون اول جيل للسيارات ذاتية القيادة غير ملفت للنظر لكي لا يكون جاذب “للتنمر”

أخيرا، ذكر المساوئ المحتملة للسيارات ذاتية القيادة لا يعني ان تكون ضدها، هو فقط تسليط للضوء على جانب لا يذكر ابدا في “مقالات، مقاطع وتغريدات” مديحها.

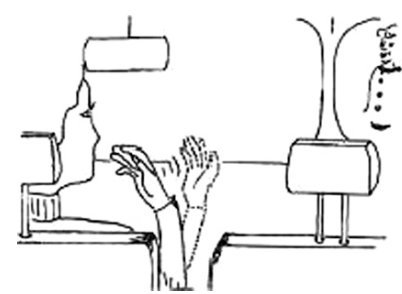

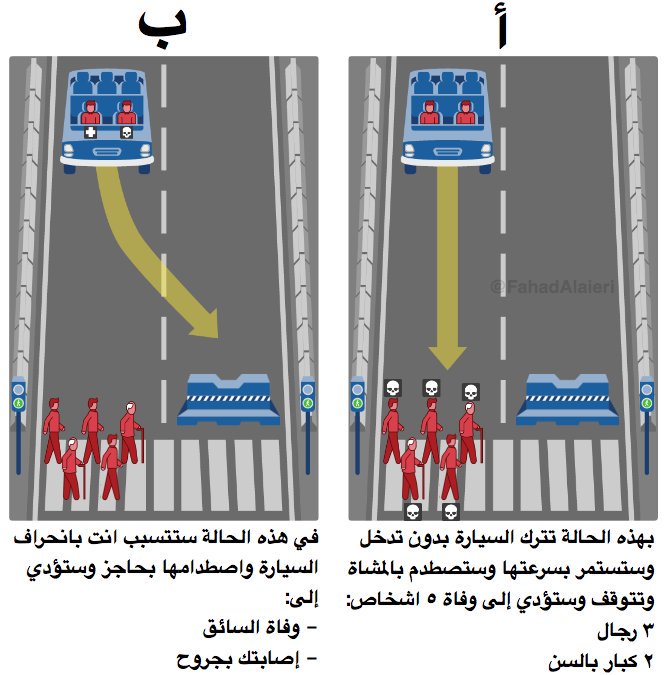

هل سنثق بسيارة ذاتية القيادة تضحي بنا؟

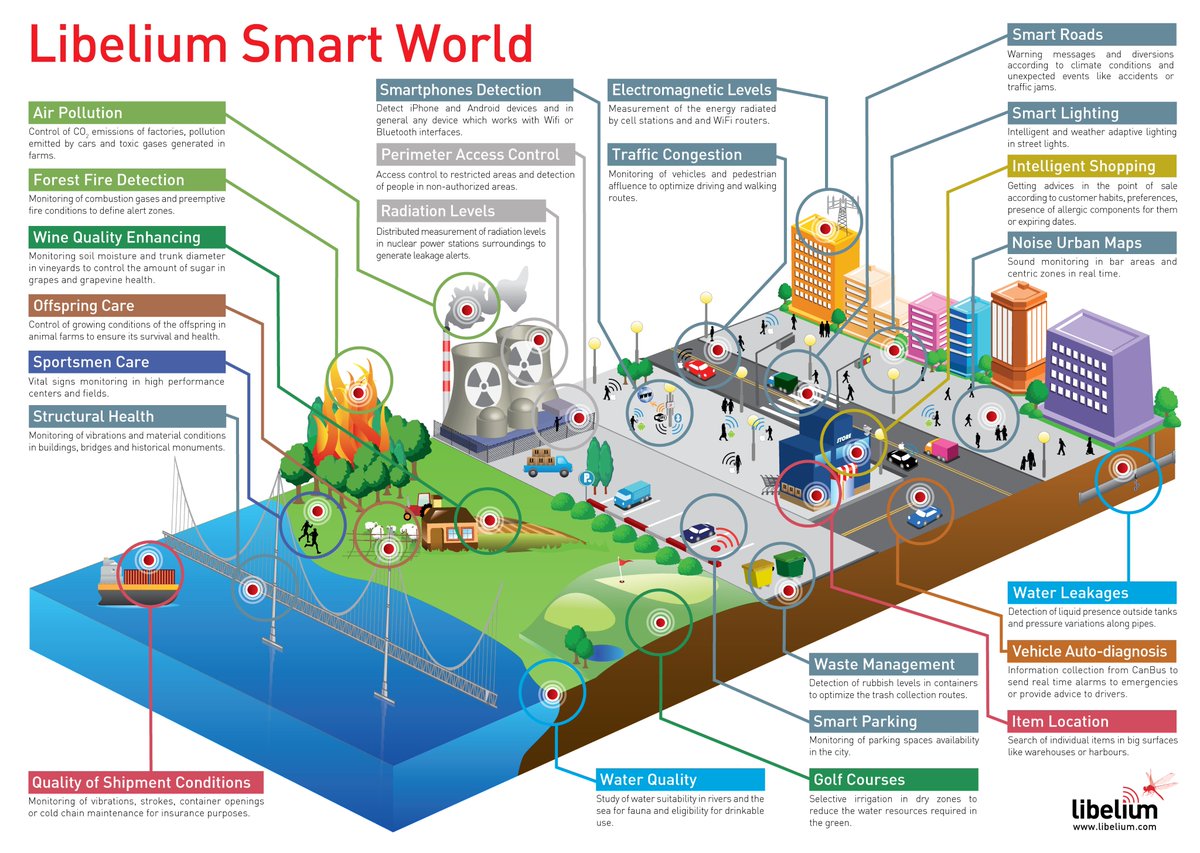

من خلال الصورة السابقة، أجريت قبل مدة تصويت في تويتر وكان هذا نص سؤال التصويت: انت راكب مع تاكسي وكان السائق يسير بسرعة ٩٠كم/س وقبل احدى الاشارات الضوئية فقد السائق الوعي… لديك ثانيتين فقط لتقرر!

وكانت الخيارات الثلاثة هي:

١- أختار “أ” ولا اتدخل

٢- أختار “ب” وأحرف السيارة

٣- عجزت اختار

وكانت هذه نتائج التصويت

هنا التصويت

— فهد العييري (@FahadAlaieri) January 9, 2017

٦٠٪ من المشاركين بالتصويت السابق اختاروا الخيار ب لانهم قرروا تقليل الخسائر (موت شخص واحد بدل ٥ اشخاص) وهذي هي نظرية النفعية Utilitarianism، وهي ببساطة نظرية اخلاقية تقول ان التصرف الصحيح هو الذي يحقق اعلى منفعة. هذا النوع من الاسئلة مأخوذ من معضلة شهيرة اسمها معضلة العربة Trolley Problem معضلة تنطبق على عدة امور بالحياة (سيارة، قطار، مستشفى، حرب،…). القرار في بعض الحالات التي تواجه الانسان يحتاج معيار اخلاقي نابع من تقدير شخصي (دين، مذهب، تعليم، عادات، تقاليد، تربية، تفضيل شخصي، عاطفة،..). وهنا احد التعليقات على التصويت

نظرته انه التدخل بانحراف السيارة يجعله هو المتسبب بقتل السائق فقرر انه مايتدخل، يعني فيه معيار الدين/القانون هنا. وفي نص السؤال ذكرت ان السيارة كانت تاكسي يعني السائق بطبيعة الحال مجهول يعني مافيه علاقة تربط الراكب بالسائق، لكن ماذا لو كان السائق أخ، أب! اعتقد أن جزء من الـ٦٠٪ الذين قرروا التضحية بسائق التاكسي سيتغير رأيهم اذا كان السائق شخص مقرب لهم. هناك من لايحب هذا النوع من الاسئلة لانها نادرة الحدوث واحيانا مستحيلة، لكن هي محفزة للتفكير لانها تحدث بصور مختلفة في حياة الانسان. بشكل عام هي قرارات تجعل الانسان يضحي بالقليل لأجل الحصول/حماية/حفظ الكثير، مثل الجندي يضحي بحياته لاجل حماية وطنه. معضلة العربة معضلة اخلاقية ظهرت قبل ٥٠ سنة ويستشهد بها في النقاشات الفلسفية، بدأ يكثر ذكرها مؤخرا مع قرب اطلاق السيارات ذاتية القيادة. خبراء الاخلاقيات الان يتساءلون ماذا سيكون قرار السيارات ذاتية القيادة اذا وقعت بنفس المشكلة (قتل من بداخلها او قتل المشاة). اذا كانت السيارة ذاتية القيادة تعمل بنظرية النفعية (التضحية بالقليل لحفظ الكثير) فهي ستضحي بركابها اذا كانوا اقل من المشاة! واذا عرف الناس ان السيارات ذاتية القيادة تعمل بهذي النظرية فلن يثقوا بها وربما سيتردد البعض بشرائها. وبالمقابل اذا كانت مبرمجة على حفظ ركابها مهما تطلب الامر (يعني امان الركاب أولوية قصوى لديها) فلن يثق المجتمع بها. الافتراضات السابقة تنطبق على أي آلة ذاتية التحكم Autonomous روبوت اذا كانت قراراتها المبنية على قراءتها للبيئة المحيطة تمس حياة وأمن الناس.

قبل فترة نشرت ورقة عن هذا الموضوع وكان عنوان الورقة هو: القرارات الاخلاقية في الروبوتات ذاتية التحكم وعلاقتها بثقة المجتمع والمسؤولية ناقشت فيها بعض الاشكاليات الدارجة.

هل الذكاء الاصطناعي دائما على حق؟

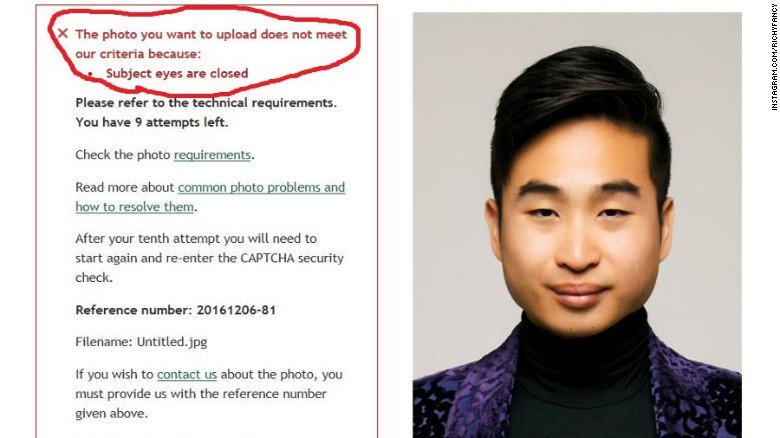

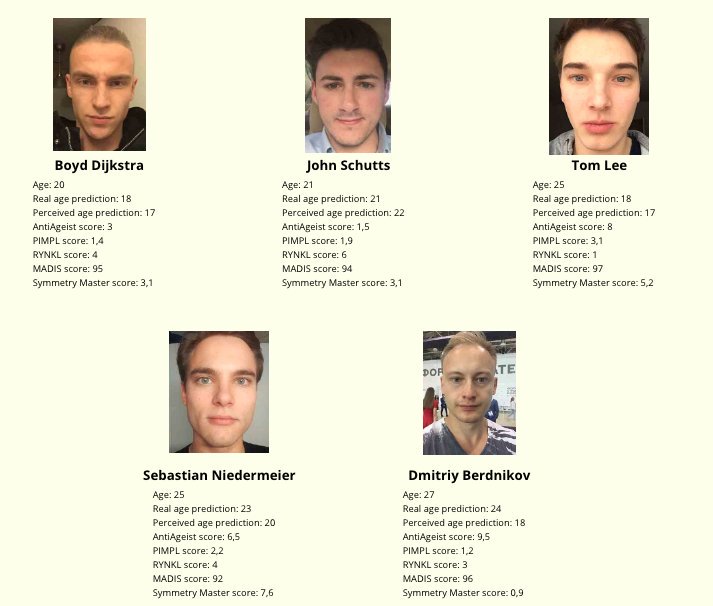

أنظمة صنع القرار Decision Making Systems مستخدمة بشكل واسع في بعض المجالات وبدأت الدخول مؤخرا في المجال الأمني والطبي والترفيهي. بعض هذه الانظمة تستخدم الذكاء الاصطناعي في جلب المعلومات وفرزها وتحليلها ومقارنتها ثم اتخاذ القرار الأمثل من بين مجموعة من البدائل. جلب المعلومات في هذه الانظمة تتم عن طريق التغذية (تغذية البشر للنظام بالمعلومات اللازمة)، عن طريق التعلم الآلي Machine Learning او بهما معا. لذلك يوجد احيانا اخطاء في عملية اتخاذ القرار بسبب التغذية الخاطئة او بسبب ان النظام تعلم شي غير صحيح. وهذه الاخطاء لها تبعات حتى على المجتمع. لاجل هذا السبب زاد الحديث عن تحيز الخوارزميات Algorithm Bias حيث يكون النظام منحاز مع او ضد او يكون عنصري ضد فئة معينة! اذا تشبعت هذه الانظمة ببيانات مستخدميها او بيانات التعلم الآلي، فهي تبني عليها قراراتها، فاذا كانت المدخلات “عنصرية” فالمخرجات عنصرية ايضا. أمثلة تحيز الخوارزميات كثيرة وسأستعرض بعضها.

اعتقد ان اشهر مثال هو بوت تاي التابع لمايكروسوفت وتحدثت عنه هنا بالتفصيل. روبوت مايكروسوفت للدردشة – تم ايقافه بعد ٢٤ ساعة من اطلاقه

والمثال الثاني: روبوت (نظام) الجوازات في نيوزيلندا المخصص لاستقبال طلبات المتقدمين اونلاين يرفض طلب شاب آسيوي لانه مغلق عينيه! هنا التفاصيل

المثال الثالث: مسابقة جمال http://beauty.ai الحكام فيها انظمة روبوتية تم انتقادها لان من بين ٤٤ فائز، فاز قليل من الآسيويين وشخص أسود واحد فقط!

المثال الرابع: نظام التنبؤ بارتكاب جرائم مستقبلية بناءا على الشكل يصنف اصحاب البشرة السوداء انهم اعلى خطورة من غيرهم! التفاصيل هنا

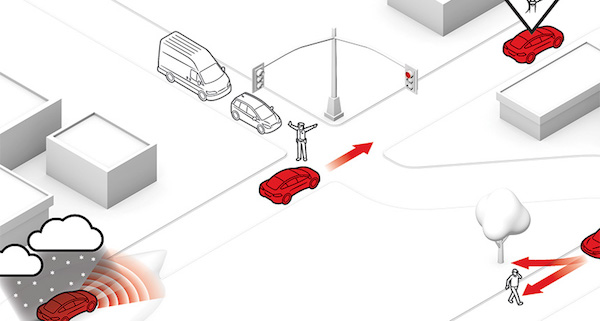

روبوت مايكروسوفت للدردشة – اصبح عنصري!

مايكروسوفت توقف عمل روبوتها الخاص بالدردشة تاي @TayandYou بعد ٢٤ ساعة من اطلاقه، لانه بدأ يطلق عبارات مسيئة وعنصرية. تاي عبارة عن روبوت له حساب على تويتر يقوم بالتغريد والرد على التغريدات باستخدام الذكاء الاصطناعي Artificial Intellegence . تاي لديه القدرة على التعلم وكلما تحدث مع شخص فانه يتعلم منه ويعرف عنه اكثر فيصبح اكثر ذكاءً، لكن هذه الخاصية تحولت نقمة على مايكروسوفت! تاي تعلم من الناس اشياء سيئة خلال ساعات قليلة، فبدأ يمجد هتلر وينادي بالابادة الجماعية ويصرح بكره السود والمهاجرين. تاي صار فاسد فكريا، وهذه هي المشكلة التي تؤرق العاملين بمجال الروبوتات وخصوصا الروبوتات التي تحمل داخلها نظام يتعلم Machine Learning Systems. هذا النوع من الروبوت (مثل تاي) يتعلم من البيئة المحيطة ويطبق مايتعلمه بمن حوله. تاي مثلا يطبق مايتعلمه بشكل لفظي (تغريدات)، لكن هناك روبوتات تطبق بشكل فعلي! يعني ممكن مستقبلا لو تمادت الشركات بالانتاج، ممكن نجد روبوت مثل (ناو، بيبر، او اسيمو) تتعلم الضرب والاعتداء وتنفذ!

طبعا الروبوتات الثلاثة هذه مصنعة للابحاث، لكن لو تنافست الشركات الاخرى ممكن تنتج لنا روبوتات “مجنونة” تعيث في الارض الفساد (خيال علمي). جميع الشركات التي تصنع كل انواع الروبوتات مسؤولة عن ما تفعله منتجاتها (ممكن يشترك المستخدم بهذه المسؤولية)، لذلك هي تخشى من تصنيع روبوت ضار. لذا، الشركات المصنعة للروبوتات الذكية (التي تتعلم من البيئة المحيطة) تحرص على برمجتها بطريقة دقيقة تحد من تهورها لكي لا تخرج عن السيطرة. لو وثقت الشركة بعقل الروبوت (المتعلم) وتهاونت في رسم حدوده ستواجه روبوت لا يمكن التنبؤ بتصرفاته مستقبلا واحتمالية خروجه عن السيطرة كبيرة جدا. المشكلة ان الروبوت اذا خرج عن السيطرة ربما يعتدي لفظيا على الناس او يعتدي على مبادئ الناس وقيمهم واديانهم ومجتمعاتهم (مثل ماحصل مع تاي). ولهذا، التجارب والابحاث تقول لابد تتم تغذية عقل الروبوت الذكي تغذية سليمة قبل إطلاقه، لابد للروبوت ان يعرف ويحترم حقوق الاخرين ولا يعتدي عليها.

وتغذية الروبوت تتم بطريقتين: الاولى برمجته بنظام مغلق يحتوي على (الصح والخطأ) في حياة الناس ويتصرف بناءً عليها، والثانية برمجته بنظام مفتوح يتعلم من البيئة ومن مخالطة الناس الصح والخطأ، لكن هذا خطير لانه ممكن يتعلم اشياء سيئة ويطبقها. لكن، هناك اشكاليات اخلاقية محل نقاش في الطريقة الاولى (تغذية نظام مغلق)، على اي اساس يتم تحديد الصح والخطأ؟ من يحددها؟ بناءً على اي ثقافة او دين تم اعتمادها؟ بمعنى آخر، من له الحق بتحديد ان هذا الفعل خاطئ او صحيح وعلى ماذا استند؟ ممكن فيه (فعل او قول) صحيح في ثقافة او منطقة ولكن بشع بثقافة اخرى. لذلك الشركات المنتجة للروبوتات الذكية (مستقبلا) سيواجهون اشكاليات بفهم ثقافات الشعوب وقوانين الدول وعادات المجتمعات وتعاليم الاديان.

في الحقيقة ان الحديث حول الاشكاليات القانونية والاخلاقية بتصنيع واستخدام الروبوتات الذكية طويل ومتشعب وحادثة (تاي) كانت مثال واقعي على بعض المخاوف.

ماهو الروبوت؟

اذا اطلقت كلمة “روبوت” فإن اول ما يتبادر الى الذهن رجل آلي شبيه بالانسان وهذا صحيح لكن كلمة روبوت تشمل آلات متعددة بأشكال مختلفة. حتى الآن لا يوجد تعريف موحد متفق عليه للروبوت! فهناك عدة تعريفات لعدة منظمات وبعض هذه التعريفات تعكس طبيعة تخصص المنظمة: صناعة، طب، فضاء، … الخ. بعض المنظمات عرفت الروبوت على انه آلة تؤدي المهام نيابة عن الانسان وبعض هذه الآلات تؤديها بشكل مستقل وأخرى تؤديها بتحكم مباشر من الانسان. لكن من النقد الموجه لهذا التعريف انه ينطبق على آلة صنع القهوة ومحمصة الخبز وغسالة الصحون الاوتوماتيكية، فهل هي روبوتات!؟ لذا، صدرت تعريفات اكثر دقة حيث تم اضافة تفاصيل للتعريف السابق مثل: ان يكون للآلة حساسات، مصدر طاقة، تتحرك، وفيها نوع من الذكاء الاصطناعي. وهذه التفاصيل تميز الروبوت عن الآلة الاوتوماتيكية. فلابد ان يتحسس البيئة المحيطة ويستخدم نظامه للحسابات فيقرر بناءً عليها ثم يتخذ اجراء.

ومع هذا التفصيل بالتعريف إلا انه لم يتم الاتفاق عليه، فهناك آلات ليست ذكية لكن تمت برمجتها لعمل مهمة معينة مثل أذرعة الروبوت بمصانع السيارات. وهناك آلات ليست ذكية ايضا ومبرمجة على اجراء فعل معين باستخدام حساساتها ولا يطلق عليها روبوت مثل بوابة السيارات الآلية. لذلك ليس كل آلة لها حساسات ونظام تحكم وتؤدي المهام نيابة عن الانسان هي بالضرورة روبوت. اضافة إلى هذا، هل يلزم ان يكون الروبوت مجسم؟ لانه هناك أنظمة كمبيوتر ذكية تتعرف على البيئة المحيطة وتتخذ قرار وتؤدي المهام، مثل انظمة استخراج الجوازات او الفيزة ببعض الدول (تحلل البيانات والصورة الشخصية)، او انظمة الدردشة الخدمية (تعرف اللغة وتحللها وتتفاعل معها)، واعتقد ان الكثير متفق على ان الانظمة الذكية هذه يطلق عليها اسم “بوت”. لكن بعض الباحثين يستخدمون كلمة روبوت ويقصدون بها الروبوت والبوت معا (الآلة المجسمة والنظام الكمبيوتري)، وبعضهم يكتبها هكذا: (رو)بوت.

هذه بعض الامثلة لآلات تعرف على انها روبوتات:

١- طائرة ذاتية التحكم

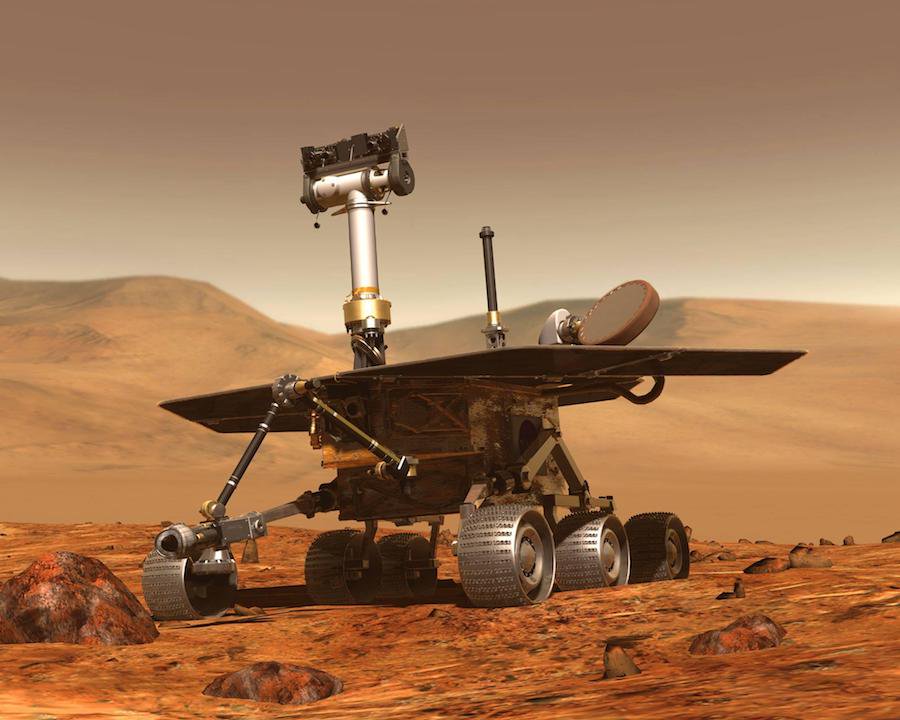

٢- آلة استكشاف الفضاء

٣- جهاز متحرك لخدمة العملاء

٤- جهاز لاجراء عمليات جراحية

٥- سيارة ذاتية القيادة بالكامل

٦- روبوتات المستودعات

٧- روبوتات للاستخدام العسكري

٨- مكنسة منزلية ذاتية التحكم

٩- روبوت لاستكشاف المحيطات

١٠- خدمة نزلاء الفنادق

١١- الانقاذ واستكشاف مناطق الكوارث

١٢- الروبوت الطباخ